FamO2O: Train Once, Get a Family: State-Adaptive Balances for Offline-to-Online Reinforcement Learning

NIPS2023的spotlight paper。关键词为 offline-to-online reinforcement learning。

本文的组织结构为:

- 算法介绍

- Motivation介绍和理论分析

一些碎碎念:

读论文的流程:

- 先把握关键词,分清楚子领域

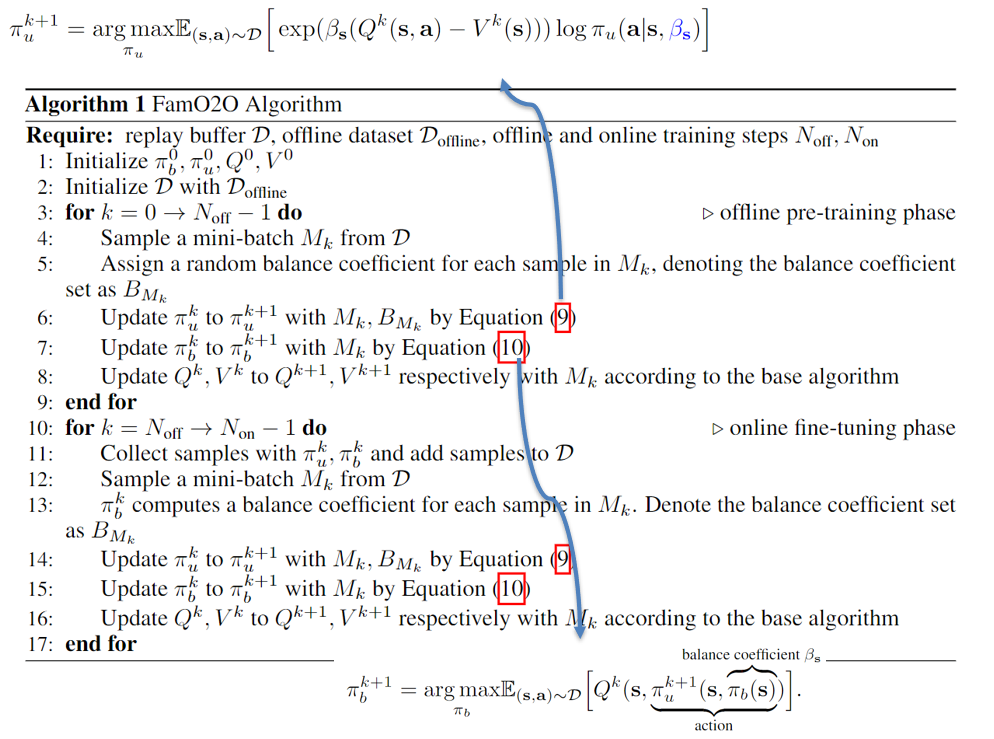

- 抛开任何理论,先看看论文的算法的流程

- 再回头看看理论,梳理清楚逻辑链,理清楚motivation

当然,2和3两步是完全可能对调的,毕竟有的论文是先看懂motivation,再看理论推导再到算法或者说代码实现,比如XQL,CQL;另一类论文就是得先看论文的算法或者说代码,再回头看一下理论,比如说本文,所以读论文的方式得根据不同的论文灵活调整,但是不同的方式都有一个共通点,就是站在作者的角度,打通论文阅读的逻辑链。

一种新型的Ensemble方法

论文标题里面有一个关键词:Family。直接举个例子吧,比如我们在Offline阶段时训练了一族AWAC,对应不同的温度系数(详见AWAC)。同时我们还训练了一个温度系数的选择器,只要输入状态s,我们就输出一个最优的温度系数,至于怎么训练的,现在可以暂时忽略。部署到Online阶段时还是一样。整个流程如下所示:

看完会不会觉得挺简单的思路,以往我们做Ensamble的时候,一般是训练得到不同seed的模型。但是这里其实灵活的通过学习超参数,从而不管是Offline还是Online都可以通过选择一个最优的模型,来达到Ensemble的效果。