Diffusion Model + RL

如果有一个包含各式各样轨迹 (trajectories) 的数据集 ,离线强化学习的目标便是从轨迹中挖掘构造出一个性能优秀的智能体 (agent) ,希望它能够直接部署至环境并获得不错的收益。

- 从 model-free offline RL 的角度,会着眼于如何更加准确的估计每个可能的状态-动作对 (state-action pair) 的价值函数,特别的是,还会尝试去设计特殊机制处理 (query) 数据集分布外 (out of distribution) 的状态-动作对。经典的论文比如CQL、IQL、XQL等等。

- 从 model-based offline RL 的角度,目标往往变为如何用这一批数据更好地拟合真实环境的环境动力学模型 (dynamic model) ,之后在这个收敛后的环境模型上应用或者拓展 online RL 的经典算法。

但是,上述方法往往没有利用到轨迹中数据的连续性,而只是将每一条轨迹分割成数个状态转移片段 (transition) ,并将每一个这样的片段作为一个独立的样本点(datapoint)进行后续训练。与之相对的,一种新的思路就是换个角度来看待这个数据集中的轨迹,把每一条轨迹视为一个样本点,从而将研究目标转变为建模整条轨迹的分布,而将轨迹的最优性作为其中的条件变量来从分布中采样轨迹。这样的思考方式就可以很好地利用 diffusion model 的强大能力来建模决策轨迹分布。

入门简介

Probabilistic Diffusion Model概率扩散模型理论与完整PyTorch代码详细解读

Diffusion Models for Reinforcement Learning: A Survey 推荐的论文合集

这一章节的论文分成两个部分,所涉及的一些术语看不懂不要紧,请按照顺序将这些论文阅读完:

- 跟RL无关的Diffusion Model,图像生成,目的是铺垫背景知识(至少应该读完DDPM和Guided Diffusion),包括:

- DDPM

- DDIM

- Score Matching

- Guided Diffusion

- 跟RL有关的Diffusion Model,包括:

- Diffuser[属于Planner一类,有点类似于MBRL]

- Diffusion QL[属于Policy一类]

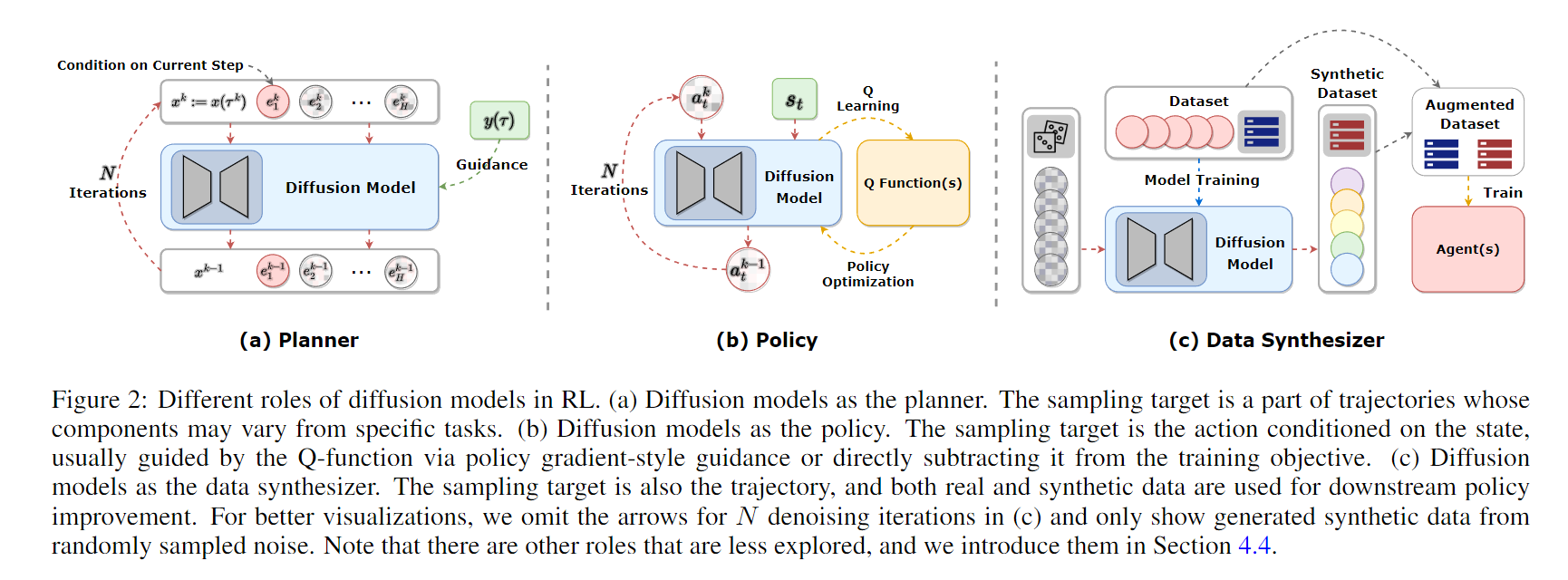

按照伟楠老师的里对于Role of Diffusion Model in RL的描述,Diffusion主要有以下三个作用: